Eine alarmierende Nachricht hat die Tech-Welt erschüttert: Berichten zufolge sind die persönlichen Daten von Millionen Nutzern von ChatGPT in die falschen Hände geraten. Wenn Sie regelmäßig künstliche Intelligenz einsetzen, ist es wichtig, dieses Thema jetzt zu verinnerlichen und zu verstehen, welche Risiken damit verbunden sind.

Was genau ist passiert?

In den geleakten Informationen fanden sich Benutzernamen, E-Mail-Adressen, Identifikationsnummern und sogar IP-Adressen von Nutzern. Solche Daten können für kriminelle Aktivitäten missbraucht werden, was eine ernsthafte Bedrohung für die Nutzer und Unternehmen darstellt, die auf die Technologie vertrauen.

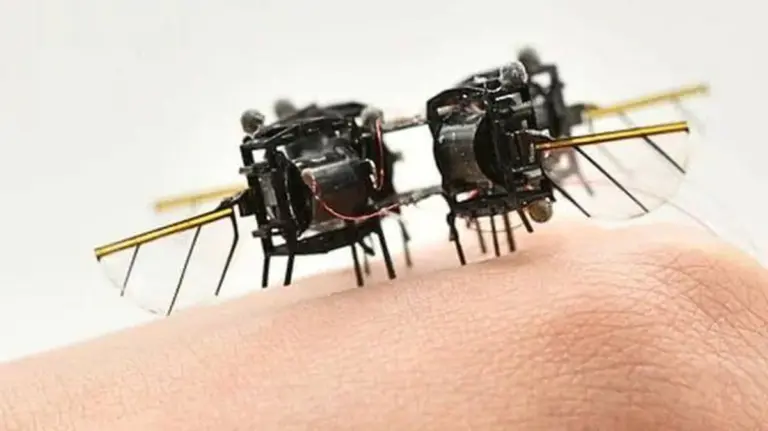

Risiken durch API-Integrationen

Darius Povilaitis, Cyber-Sicherheitschef von Telia, erklärt, dass alle Integrationen mit KI-Modellen bestimmte Risiken mit sich bringen. Obwohl KI-Modelle an sich sicher sind, können Schnittstellen Sicherheitslücken öffnen, die von Kriminellen ausgenutzt werden.

- Eindeutige Zugriffskontrollen

- Minimierung der Datenübertragung

- Echtzeiteingriffe zur Überwachung von Datenflüssen

Nutzen Sie ChatGPT sicher?

ChatGPT hat sich in vielen Bereichen bewährt, von der Texterstellung bis zur Programmierung. Aber wissen Sie wirklich, wie Sie es sicher nutzen? Die Antworten könnten Sie überraschen.

Empfehlungen für Unternehmen

Um Sicherheitsrisiken zu minimieren, sollten Unternehmen ihre Daten nach Sensitivität kategorisieren. Hier sind einige Tipps:

- Verdeckt Daten weitergeben.

- Achten Sie darauf, keine persönlichen Informationen oder Passwörter zu teilen.

- Regelmäßig durch interne Audits überprüfen, welche Daten extern übermittelt werden.

Die Gefahr der Schatten-KI

Ein weiteres großes Problem ist die Verwendung von „Schatten-KI“, bei der Mitarbeiter ohne Genehmigung eigene KI-Lösungen nutzen. Laut einer Studie von Cisco wissen 60 Prozent der IT-Abteilungen nichts von dieser Praxis.

Um die Daten der Kunden in der Zukunft zu schützen, ist es entscheidend, dass Unternehmen sichere und benutzerfreundliche KI-Tools bereitstellen. Die Trennung von Arbeits- und Privatkonten ist dabei fundamental.

Praktische Sicherheitsmaßnahmen für Nutzer

Privatanwender können in den ChatGPT-Einstellungen die Funktion zur Verwendung von Gesprächsinformationen durch die KI deaktivieren und die zwei-Faktor-Authentifizierung aktivieren. Auch Sicherheitsanwendungen wie „Telia Safe“ bieten zusätzlichen Schutz und warnen sofort bei Datenlecks.

Was sind Ihre Erfahrungen mit ChatGPT? Hatten Sie schon einmal Bedenken hinsichtlich der Datensicherheit? Teilen Sie Ihre Gedanken in den Kommentaren unten mit uns!